清華團隊用「任務關系」破解AI學完就忘的難題,提出的H-embedding guided hypernet先算新舊任務的親疏關系,再讓超網絡按關系生成專屬模型參數,低維小向量即插即用,在ImageNet-R等測試把遺忘率再降一成。

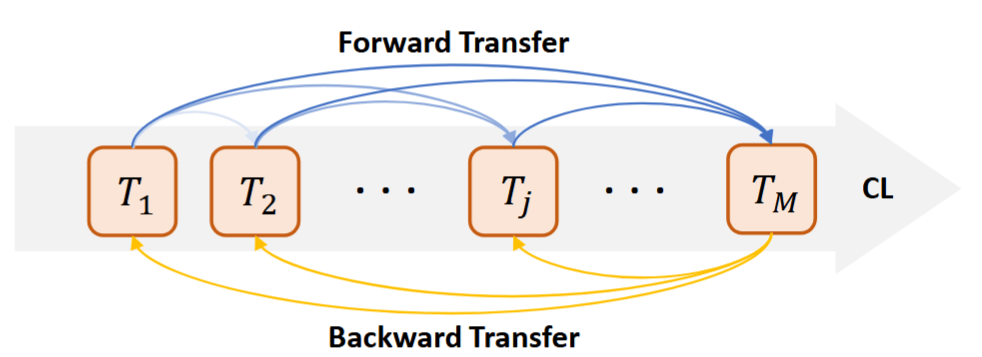

持續學習(Continual Learning,CL)是人工智能系統邁向長期智能的重要能力。其核心目標是讓模型在任務序列中不斷吸收新知識,同時維持甚至提升舊任務的表現。

然而,在主流深度學習框架下,模型在學習新任務時往往會顯著遺忘舊知識,即「災難性遺忘」(Catastrophic Forgetting),這是限制持續學習走向大規模實用的關鍵瓶頸。

現有CL方法大致可分為三類:基于數據回放的重放方法、基于參數約束的正則化方法,以及基于模型結構的動態擴展方法。盡管它們都在不同程度上緩解了遺忘,但一個根本問題始終被忽視:

大多數CL方法仍從「模型中心」視角出發,而缺乏對任務之間內在關系的建模和利用。

然而,任務關系直接決定了知識遷移的方向與效率:哪些任務之間協同度高,哪些任務之間沖突大,哪些舊任務對新任務有幫助,哪些新任務可能破壞已有能力——這些信息對于穩健的持續學習至關重要。

為解決這一長期存在的空白,清華大學研究提出了一種「任務關系中心」(task-relation-centric)的新型CL方案:H-embedding引導的超網絡(Hypernetwork)持續學習框架。